Continua la rassegna delle tecnologie del passato: questa volta parliamo del Super Nintendo. La console con cui quasi tutti i trentenni hanno giocato per la prima volta a Super Mario, Street Fighter, Final Fantasy e tutti quei giochi che col passare degli anni hanno rappresentato delle serie di culto che ancora adesso hanno milioni di fans e vengono pubblicate per le console di ultime generazione.

Nato nel 1990 come evoluzione naturale del Nintendo Nes, il Super Nintendo, (ma potete chiamarlo anche Super Nes e/o Super Famicon) in breve tempo divenne la console più diffusa sul mercato, ingaggiando una battaglia di vendite con il rivale dell'epoca, il Sega Mega Drive che poteva vantare un catalogo giochi di tutto rispetto, capeggiato da Sonic the Hedgehog. In particolare la console a 16 bit di Nintendo ottenne il predominio assoluto in Giappone, dove fino alla uscita di scena nel 1999 rimase la console più venduta (e non è un caso che la maggior parte dei giochi siano stati pubblicati solo nel paese del Sol Levante, lasciando a team di appassionati europei la loro traduzione per poterli giocare con gli emulatori anche anni dopo la loro uscita).

In Europa ed America invece la situazione era più equilibrata, anche perchè i rivali di Sega potevano contare su supporti ottici per i giochi, mentre il Super Famicon, uscito tra l'altro con 2 anni di ritardo rispetto al Giappone, restava ancorato all'uso delle cartucce che per un certo verso venivano viste come un supporto antiquato, anche se la qualità grafica dei giochi non aveva niente da invidiare ai giochi pubblicati su CD.

La cosa che distingueva il Super Nintendo dalla concorrenza era la possibilità di potenziare la console tramite circuiti integrati direttamente nelle cartucce dei giochi: questo permetteva di pubblicare giochi con animazioni e grafica migliore senza preoccuparsi delle limitazioni dell'hardware originario.

Quest'ultimo prevedeva :

- Processore 65c816 a16-bit a 2,68-3,58 MHz

- 1 Mbit (128 Kbyte) di memoria RAM

- Processore dedicato per la gestione della grafica a 16-bit, 0,5 Mbit (64 Kb) Video RAM

- Risoluzione massima 512 x 448, palette di 32.768 colori, massimo 256 contemporanei su schermo

- Massimo 128 sprites su schermo, dimensione massima 64 x 64

- Dimensione minima/massima delle cartucce: 2 Mbit - 48 Mbit

- Chip audio: 8-bit Sony SPC700 a 8-bit, 8 canali stereo e 64 Kb di memoria dedicata. È in grado di produrre campionamenti audio ADPCM al massimo di 4-bit.

- Adattatore (AC ADAPTER PAL): Input AC 220/230 V, 50 Hz, 17 watts; Output AC 9/9,4 V, 1.3 A.

Le cartucce venivano inserite dall'alto e potevano essere estratte sia manualmente che tramite il tasto Eject centrale, ai suoi fianchi i tasti di accensione/spegnimento e Reset permettevano di gestire la console per le operazioni più importanti. La cosa che però contraddistingue lo SNES dalla massa sono i controller dalla forma che ha fatto scuola negli anni successivi, i 4 tasti azione permettevano di eseguire un numero notevole di combo ed azioni speciali, ed erano liberamente configurabili nei giochi in modo da poterli usare a nostro piacimento.

Come già accennato in precedenza nelle cartucce dei giochi era possibile inserire tutta una serie di circuiti di espansione che permettevano di migliorare le prestazioni della console, come ad esempio chip dedicati alla grafica, all'espansione della memoria o all'overclock del processore (è il caso dei chip Super FX e Super FX 2 che portavano la velocità del processore fino a 10 MHz e oltre). Tramite questo accorgimento la console poteva far girare anche giochi sviluppati con una tecnologia più recente senza risentirne in termini di velocità e prestazioni e senza il bisogno di ulteriori moduli di espansione da comprare a parte come accadeva per la concorrenza.

La console viene tolta dal mercato nel 1999, sebbene nel 1997 fosse entrata in commercio la sua versione a 64 bit, il Nintendo 64 e nello stesso periodo fosse stata commercializzata anche una versione aggiornata del Super Famicon che portava in dote componentistica più moderna.

Anche se non più in commercio i nostalgici come me (che ho amato alla follia Tales of Phantasia) possono provare le emozioni di un tempo utilizzando uno dei tanti emulatori disponibili in rete, con cui si potrà di nuovo far risuonare la mitica musichetta di Super Mario World e liberare la principessa dalle tartarughe cattive.

La facilità d'uso e la semplicità con cui era possibile realizzare programmi compatibili con esso, unite al prezzo di vendita inferiore rispetto agli altri modelli in commercio nello stesso periodo sono stati i fattori fondamentali che hanno permesso al Commodore 64 di diventare il computer più venduto al mondo. Le "origini della specie" partono dal suo predecessore, il Vic-20, di cui riprende le linee e la base costruttiva (scelta dettata dalla necessità di tenere bassi i costi di produzione).

La facilità d'uso e la semplicità con cui era possibile realizzare programmi compatibili con esso, unite al prezzo di vendita inferiore rispetto agli altri modelli in commercio nello stesso periodo sono stati i fattori fondamentali che hanno permesso al Commodore 64 di diventare il computer più venduto al mondo. Le "origini della specie" partono dal suo predecessore, il Vic-20, di cui riprende le linee e la base costruttiva (scelta dettata dalla necessità di tenere bassi i costi di produzione).

Il keygen è un programmino che genera la chiave di registrazione del software che vogliamo "piratare". Utilizza lo stesso algoritmo che è alla base della creazione del seriale che troveremmo sulla licenza del software se lo acquistassimo in modo regolare e non modifica minimamente i files dell'installazione, si limita a fornire il codice necessario a validarne l'installazione.

Il keygen è un programmino che genera la chiave di registrazione del software che vogliamo "piratare". Utilizza lo stesso algoritmo che è alla base della creazione del seriale che troveremmo sulla licenza del software se lo acquistassimo in modo regolare e non modifica minimamente i files dell'installazione, si limita a fornire il codice necessario a validarne l'installazione.  Partiamo dal kernel, questa nuova distribuzione si basa su Linux 3.0, quindi è compatibile con un gran numero di CPU, sia un pò vecchiotte che di ultima generazione, permette una migliore gestione del WI-FI, miglioramento di driver già esistenti e compatibilità con la maggior parte dell'hardware più recente. In parole povere può essere installata sia sui computer più recenti che su macchine con 3-4 anni di vita (seppur rinunciando a qualche orpello grafico e con prestazioni leggermente inferiori alle aspettative).

Partiamo dal kernel, questa nuova distribuzione si basa su Linux 3.0, quindi è compatibile con un gran numero di CPU, sia un pò vecchiotte che di ultima generazione, permette una migliore gestione del WI-FI, miglioramento di driver già esistenti e compatibilità con la maggior parte dell'hardware più recente. In parole povere può essere installata sia sui computer più recenti che su macchine con 3-4 anni di vita (seppur rinunciando a qualche orpello grafico e con prestazioni leggermente inferiori alle aspettative).  In pratica dopo aver acceso il Pc e fatto il login in Windows 7 invece di comparire il desktop compare una bella schermata nera da cui non puoi fare nulla, l'unica cosa che emette segni di vita è il led dell'hard disk che indica che il PC sta funzionando, pur non emettendo il minimo segnale a video.

In pratica dopo aver acceso il Pc e fatto il login in Windows 7 invece di comparire il desktop compare una bella schermata nera da cui non puoi fare nulla, l'unica cosa che emette segni di vita è il led dell'hard disk che indica che il PC sta funzionando, pur non emettendo il minimo segnale a video.

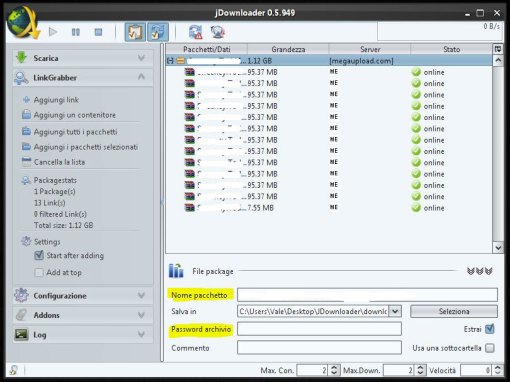

Concludiamo l'articolo ricordando ai lettori che questi due programmi sono solo una piccolo assaggio, e che in rete se ne possono trovare molti altri il cui funzionamento è simile.

Concludiamo l'articolo ricordando ai lettori che questi due programmi sono solo una piccolo assaggio, e che in rete se ne possono trovare molti altri il cui funzionamento è simile.  Innanzitutto partiamo col descrivere cosa ci arriva nella confezione al momento in cui il tecnico viene ad installare l'asdl a casa nostra. Il router, i vari cavi necessari al collegamento ed i filtri da applicare alle prese telefoniche. Partiamo subito col dire che spesso sono proprio questi la causa di alcuni problemi : bisogna avere l'accortenza di mettere un filtro ad ogni presa telefonica cui è collegato un apparecchio, altrimenti avremo frequenti disconnessioni e problemi vari facilmente risolvibili ma che a un utente inesperto possono sembrare insormontabili.

Innanzitutto partiamo col descrivere cosa ci arriva nella confezione al momento in cui il tecnico viene ad installare l'asdl a casa nostra. Il router, i vari cavi necessari al collegamento ed i filtri da applicare alle prese telefoniche. Partiamo subito col dire che spesso sono proprio questi la causa di alcuni problemi : bisogna avere l'accortenza di mettere un filtro ad ogni presa telefonica cui è collegato un apparecchio, altrimenti avremo frequenti disconnessioni e problemi vari facilmente risolvibili ma che a un utente inesperto possono sembrare insormontabili.  Sul lato destro del pannello di controllo si trovano i comandi per configurare vari aspetti, tra questi soffermiamoci sulla porta usb, da qui possiamo scegliere se utilizzare la porta usb posta sul retro del router per collegarci un hd esterno e creare un hard dsik di rete oppure una stampante, per avere una stampante di rete.

Sul lato destro del pannello di controllo si trovano i comandi per configurare vari aspetti, tra questi soffermiamoci sulla porta usb, da qui possiamo scegliere se utilizzare la porta usb posta sul retro del router per collegarci un hd esterno e creare un hard dsik di rete oppure una stampante, per avere una stampante di rete.  Questo software permette di creare con pochi semplici passaggi una copia identica dell'hard disk del proprio computer, sistema operativo compreso. L'utente potrà creare un disco autoavviante da cui effettare il ripristino dei dati in pochissimo tempo.

Questo software permette di creare con pochi semplici passaggi una copia identica dell'hard disk del proprio computer, sistema operativo compreso. L'utente potrà creare un disco autoavviante da cui effettare il ripristino dei dati in pochissimo tempo.